HABEN SIE FRAGEN?

ZUM KONTAKTFORMULARRÜCKRUFSERVICE

JETZT RÜCKRUF VEREINBARENKunden, die uns vertrauen

Wie wird deine Website bei Google überhaupt sichtbar? Die Antwort beginnt ganz am Anfang – beim Webcrawling. Bevor Inhalte gerankt werden, müssen sie erst einmal gefunden werden. Genau hier kommen sogenannte Webcrawler ins Spiel. Sie durchforsten das Internet, analysieren Seitenstrukturen und sammeln Informationen für den Suchmaschinenindex. Für deine Sichtbarkeit bedeutet das: Ohne reibungslosen Crawl keine Top-Platzierung. Als erfahrene Online-Marketing-Agentur wissen die SUCHHELDEN, worauf es technisch ankommt – und wie du Webcrawling für nachhaltiges SEO-Marketing nutzt.

Was macht ein Webcrawler und warum ist er so wichtig für SEO?

Laut Definition ist der Webcrawler ein automatisiertes Programm, das Webseiten systematisch durchsucht und dabei alle erreichbaren Inhalte erfasst. Er folgt internen und externen Links, liest Metadaten aus und entscheidet, welche Inhalte für den Suchindex relevant sind. Diese Crawler legen die Grundlage für jede Indexierung. Nur wenn deine Seite für sie zugänglich und strukturiert ist, kann sie überhaupt im Ranking erscheinen.

Webcrawler, Spider oder Bot – gibt es einen Unterschied?

Die Begriffe Webcrawler, Spider und Bot werden im SEO-Kontext häufig synonym verwendet. Technisch erfüllen sie alle dieselbe Aufgabe: Sie analysieren Websites, entdecken neue Inhalte und bilden die Basis für die Indexierung. Wichtig ist dabei das Verständnis, wie diese automatisierten Prozesse ablaufen, und welche Rolle sie für deine Sichtbarkeit spielen. Wer sich mit dem Webcrawling im Bereich der Suchmaschinenoptimierung beschäftigt, erkennt schnell: Strukturierte Daten sind für hohe Platzierungen in den Suchergebnissen essentiell.

Ein Webcrawler beginnt seine Arbeit meist mit sogenannten Seed-URLs – das sind bekannte Startadressen aus früheren Durchläufen oder aus einer eingereichten Sitemap. Von dort aus analysiert der Bot den HTML-Code der Seite und extrahiert alle enthaltenen Hyperlinks. Diese führen zu neuen, bisher nicht gecrawlten Seiten, die anschließend in einer Warteschlange landen, der sogenannten Frontier Queue. Welche dieser Seiten als Nächstes besucht wird, entscheidet ein Scheduler. Er bewertet Kriterien wie Aktualität, Domainautorität oder Strukturprioritäten aus der Sitemap. Sobald die Seite geladen ist, kommt der Parser zum Einsatz: Er zerlegt den Code in seine Bestandteile und bereitet ihn für die Weiterverarbeitung auf. So entsteht ein digitales Abbild deiner Website – bereit zur Indexierung.

Neben HTML analysiert ein Webcrawler auch CSS-Dateien, JavaScript, PDFs und andere eingebundene Ressourcen, um die tatsächliche Struktur und Darstellung der Website vollständig zu erfassen. Der technische Aufbau eines Crawlers im Web hängt von der Leistungsfähigkeit des Bots und den Ressourcen der Website ab. Entscheidend für die Häufigkeit und Tiefe des Crawlings ist das sogenannte Crawl-Budget. Dieses wird von Suchmaschinen wie Google individuell zugewiesen – abhängig von Seitenumfang, Servergeschwindigkeit und technischer Sauberkeit. Wenn du regelmäßig neue Inhalte veröffentlichst und eine schlanke, valide Seitenstruktur pflegst, sorgst du dafür, dass die wichtigsten Seiten priorisiert behandelt werden. Eine optimierte Sitemap, kurze Ladezeiten und saubere Quelltexte helfen dabei, das volle Crawling-Potenzial auszuschöpfen.

Bekannt aus*

Nicht jeder Crawler verfolgt dasselbe Ziel – je nach Aufgabe, Inhaltstyp oder Ausrichtung unterscheiden sich Aufbau, Funktionsweise und Reichweite. Ein präzises Verständnis dieser Unterschiede hilft dir, das Verhalten auf deiner Website besser zu interpretieren und technische Optimierungen darauf abzustimmen. Wer weiß, welcher Crawler im Web weit verbreitete Inhalte sammelt und welcher gezielt Spezialdaten sucht, kann seine Struktur optimal ausrichten.

General Purpose Crawler

Diese Allrounder bilden das Rückgrat der großen Suchmaschinen. Der Googlebot oder der Bingbot crawlen täglich Milliarden von Seiten, um möglichst vollständige und aktuelle Suchergebnisse zu gewährleisten. Auch Yandex oder DuckDuckGo nutzen universelle Bots, um öffentlich zugängliche Inhalte in ihre Indizes zu überführen. Sie durchsuchen das Web flächendeckend – unabhängig von Thema oder Seitentyp.

Focused Crawler

Im Gegensatz zu General Purpose Crawler verfolgen Focused Crawler ein enges Themenspektrum. Sie durchforsten nur Seiten, die für ein spezifisches Thema oder eine Branche relevant sind, etwa für Preisvergleiche oder wissenschaftliche Studien. Gerade bei Nischenprojekten oder Fachportalen lohnt es sich, für solche Bots technisch zugänglich und strukturell sauber aufgestellt zu sein.

Specialized Crawler

Diese spezialisierten Bots konzentrieren sich auf bestimmte Inhaltstypen, etwa Bilder, Videos oder mobile Ansichten. Der Googlebot-Image extrahiert beispielsweise Alt-Texte, Kontextinformationen und Dateiformate, während Mobile-Crawler prüfen, ob eine Seite auch auf Smartphones schnell lädt und korrekt angezeigt wird. Mit einem klaren Verständnis dieser Bots lässt sich die Sichtbarkeit in vertikalen Suchen stärken.

Distributed & Parallel Crawler

Um das riesige Datenvolumen im Netz effizient zu bewältigen, nutzen Suchmaschinen verteilte Crawler-Systeme. Hierbei übernehmen viele Server gleichzeitig unterschiedliche Aufgaben innerhalb eines Crawling-Prozesses. Diese parallele Arbeitsweise beschleunigt die Verarbeitung, reduziert Ausfallrisiken und macht es möglich, auch sehr große Websites regelmäßig vollständig zu durchsuchen.

Echtzeit-Crawler

Wenn Aktualität zählt, kommen Echtzeit-Crawler zum Einsatz. Sie scannen das Netz fortlaufend nach neuen Inhalten – ob Tweets, News oder sicherheitsrelevante Veränderungen. Besonders Plattformen für Medienbeobachtung oder Cybersicherheit setzen auf diese Technologie, um innerhalb von Sekunden auf neue Inhalte zu reagieren. Für SEO bedeutet das: Relevanz und frische Inhalte werden sofort sichtbar.

Obwohl Webcrawling und Webscraping im Alltag oft gleichgesetzt werden, verfolgen sie vollkommen unterschiedliche Ziele – sowohl technisch als auch funktional. Während ein Webcrawler dazu dient, URLs zu entdecken und für die Indexierung vorzubereiten, liegt der Fokus beim Scraping auf der direkten Extraktion strukturierter Daten. Der Crawler analysiert Seiteninhalte oberflächlich, folgt Links und kartiert das Web – er erstellt keinen Datenbestand, sondern bereitet Inhalte für Suchmaschinen auf. Scraping hingegen greift gezielt Informationen ab, etwa Preise, Texte oder Kontaktdaten und nutzt dafür teilweise komplexe Technologien wie Headless-Browser oder automatisierte DOM-Parser.

Im Gegensatz zum Webcrawling durch Suchmaschinen, das weitgehend akzeptiert und sogar gewünscht ist, bewegt sich Webscraping häufig auf juristisch unsicherem Terrain. Wird dabei gegen die AGB einer Website verstoßen, urheberrechtlich geschützte Inhalte kopiert oder massenhaft Daten abgegriffen, kann es rechtlich problematisch werden. Besonders kritisch ist das systematische Auslesen ganzer Datenbanken, etwa im kommerziellen Umfeld. Der Gesetzgeber unterscheidet hier zwischen technischer Zugriffserlaubnis und rechtlicher Zulässigkeit. Deshalb ist es essenziell, beim Einsatz von Scraping-Tools auf die Funktionalität sowie die Einhaltung datenschutz- und urheberrechtlicher Rahmenbedingungen zu achten.

Rechtlich betrachtet bewegen sich Webcrawling und Scraping in einem komplexen Spannungsfeld. Zwar gelten technische Signale wie die robots.txt als etablierter Standard, doch sie entfalten keine rechtliche Bindung. Gesetzlich maßgeblich sind hingegen Vorgaben aus dem Urheberrecht, der DSGVO sowie die AGB einzelner Websites. Werden Inhalte gespeichert oder personenbezogene Daten erfasst, greifen klare Regulierungen – gerade im europäischen Raum. Während Suchmaschinen durch legitime Interessen gedeckt sind, kann das massenhafte Auslesen von Inhalten durch Dritte rechtliche Risiken bergen. Deshalb ist es entscheidend, technische Verfahren mit datenschutz- und wettbewerbsrechtlichen Rahmenbedingungen abzustimmen.

robots.txt als technischer Hinweis, nicht als Gesetz

Die robots.txt regelt, welche Bereiche einer Website ein Crawler auslesen darf – allerdings nur auf freiwilliger Basis. Sie besitzt keine rechtliche Verbindlichkeit, sondern dient der digitalen Fairness. Rechtlich entscheidend sind Urheberrecht und Datenschutz, nicht die robots.txt allein.

AGB, DSGVO und Urheberrecht definieren die Grenzen

Sobald Inhalte gespeichert oder personenbezogene Daten verarbeitet werden, gelten gesetzliche Regeln. Die DSGVO schützt Nutzerinformationen, das Urheberrecht regelt geistiges Eigentum. Werden AGB verletzt, drohen zivilrechtliche Konsequenzen – in Einzelfällen auch Sanktionen nach dem Wettbewerbsrecht.

Wenn der Webcrawler nicht durchkommt, bleibt dein Content unsichtbar

Webcrawling ist weit mehr als ein rein technischer Vorgang – es ist die Basis, auf der deine gesamte Sichtbarkeit bei Google & Co. aufbaut. Gerade für KI-SEO spielt eine saubere Crawling-Struktur eine Schlüsselrolle, weil generative Systeme Inhalte nur dann zuverlässig erfassen, wenn der Quellcode fehlerfrei und semantisch klar aufbereitet ist. Dabei zählt nicht nur, dass Inhalte vorhanden sind, sondern auch, wie sie ausgeliefert werden: sauber codiert, logisch verlinkt und maschinenlesbar. Technische Qualität wird so zur Voraussetzung für organischen Erfolg. Wird deine Website nicht vollständig gecrawlt, bleibt selbst der relevanteste Content für Suchmaschinen unsichtbar und damit für deine Zielgruppe ebenso.

Ein effizienter Crawl entscheidet darüber, wie viele und welche Inhalte deiner Website überhaupt im Google-Index landen. Faktoren wie die interne Linkstruktur, der Statuscode einzelner Seiten und die Logik deiner URL-Architektur beeinflussen maßgeblich, wie zuverlässig Crawler deine Inhalte im Web erfassen. Technische Barrieren wie defekte Links oder unabsichtlich gesetzte noindex-Tags führen häufig dazu, dass wertvolle Seiten gar nicht erst berücksichtigt werden – mit direkten Auswirkungen auf deine organische Sichtbarkeit.

Auch die Crawl-Frequenz wird nicht zufällig festgelegt. Sie richtet sich unter anderem nach der Server-Reaktionszeit und der technischen Stabilität deiner Seite. Ein langsamer Pagespeed kann dazu führen, dass deutlich weniger Inhalte pro Sitzung verarbeitet werden. Damit deine Inhalte überhaupt in die Bewertung der Google-Ranking-Faktoren einfließen, müssen sie erst vollständig erreichbar und korrekt ausgeliefert sein – ein Aspekt, der häufig unterschätzt wird.

Wir haben für euch die wichtigsten Google Ranking-Faktoren für das Jahr 2025 zusammengefasst und in einer kompletten Checkliste anschaulich dargestellt.

Die Art und Weise, wie ein Webcrawler deine Inhalte verarbeitet, hängt maßgeblich von deiner technischen Infrastruktur ab. Mit den richtigen Stellschrauben lässt sich beeinflussen, welche Seiten Vorrang erhalten, welche ausgeschlossen bleiben und wie effizient die vorhandenen Ressourcen genutzt werden. In der SEO-Optimierung zählt diese Steuerung zu den unterschätzten Hebeln – sie schafft die Grundlage dafür, dass deine Inhalte überhaupt im Suchmaschinenindex ankommen.

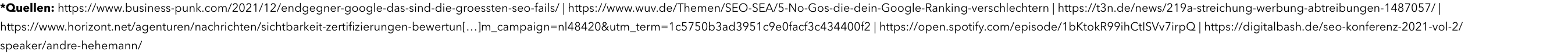

Effizientes Webcrawling beginnt bei der richtigen Priorisierung. Die robots.txt-Datei dient dabei als zentrale Kontrollinstanz: Sie bestimmt, welche Bereiche einer Website von Suchmaschinen-Bots durchsucht werden dürfen. Zusätzlich helfen Meta-Robots-Tags auf Seitenebene dabei, unwichtige Inhalte wie interne Filterseiten von der Indexierung auszuschließen. Auch Canonical-Tags, hreflang-Anweisungen für Sprachvarianten und strukturierte Pagination beeinflussen die Art und Weise, wie Suchmaschinen deine Inhalte erfassen und einordnen. Eine präzise Crawl-Steuerung ist gerade im internationalen SEO von Bedeutung – hier entscheidet sie mit darüber, ob lokal relevante Inhalte in der richtigen Sprachversion auffindbar sind.

robots.txt prüfen: Blockiert sie nur irrelevante Inhalte und lässt wichtige Ressourcen (z. B. CSS/JS) frei?

Meta-Tags korrekt einsetzen: noindex und nofollow nur bei unbedeutenden Seiten wie internen Suchergebnissen oder Dankeseiten verwenden.

XML-Sitemap pflegen: Enthält sie alle relevanten, erreichbaren URLs? Wurde sie in der Google Search Console hinterlegt?

URL-Strategie definieren: Klare, sprechende URLs ohne unnötige Parameter verbessern die Crawlbarkeit.

Interne Verlinkung optimieren: Wichtige Seiten müssen mehrfach erreichbar sein – idealerweise über thematisch verwandte Seiten.

Duplicate Content vermeiden: Canonicals konsolidieren Duplikate bei Filteroptionen, Varianten oder Druckansichten.

Technische Performance sichern: Guter Pagespeed reduziert Crawler-Last und erhöht die Indexierungsrate.

Die Vorstellung, dass Webcrawler sich planlos durch Seiten hangeln, ist längst überholt. Wer relevante Bereiche gut strukturiert, liefert Suchmaschinen eine klare Navigationshilfe durch die eigene Website. Diese Struktur zeigt sich nicht nur in der Linkarchitektur, sondern auch in technischen Attributen wie Canonicals und Sitemap-Hierarchien. Besonders bei großen Projekten oder E-Commerce-Seiten entscheidet eine durchdachte Crawling-Strategie darüber, ob wichtige Kategorien im Ranking auftauchen – oder im Index untergehen. Ein präzises Crawling-Setup ist damit ein zentraler Baustein erfolgreicher SEO-Optimierung auf technischer Ebene.

Diese Webcrawler simulieren Suchmaschinen-Bots lokal oder cloudbasiert und sind echte Allrounder für die technische SEO-Analyse. Screaming Frog und Sitebulb prüfen Metadaten, Überschriften, Weiterleitungen und Seitenstruktur effizient auf Tausenden URLs. JetOctopus geht noch weiter: Als Cloud-Lösung vereint es klassische Crawls mit Logfile-Daten und liefert tiefgreifende technische Insights – ideal für große Projekte. Diese Tools machen blinde Flecken sichtbar und helfen dabei, Crawling- und Indexierungsprobleme frühzeitig zu beheben.

Die Google Search Console zählt zu den wichtigsten kostenlosen Tools. Sie liefert dir authentische Webcrawling-Daten direkt von Google, ohne Umwege, ohne Schätzwerte. Du erkennst dort, wie oft der Googlebot deine Seiten besucht, ob Fehler wie 404- oder 5xx-Statuscodes auftreten und welche Seiten im Index fehlen. Besonders hilfreich: das URL-Prüftool, das dir anzeigt, wie Google deine Seite sieht, sie rendert und ob sie tatsächlich indexiert wird.

Wenn deine Website Millionen von URLs umfasst, brauchst du skalierbare Lösungen wie Botify. Diese Enterprise-Tools kombinieren Cloud-Crawling, Logfile-Analyse und Performance-Monitoring in einem zentralen Dashboard. Besonders bei großen E-Commerce- oder News-Portalen helfen sie dabei, das Crawl-Budget effizient einzusetzen und strukturelle Schwächen systematisch zu identifizieren. Für SEO-Teams im Konzernumfeld sind sie unverzichtbar – etwa um technische Bottlenecks zu erkennen und Potenziale in Echtzeit sichtbar zu machen.

Anders als simulierte Crawls zeigen dir Logfiles die echte Interaktion zwischen Webcrawlern und deiner Seite. Jede einzelne Server-Anfrage – ob von Googlebot, Bingbot oder unbekannten Bots – wird dort protokolliert. Diese Rohdaten sind Gold wert für deine SEO-Analyse: Du siehst exakt, welche Seiten häufig gecrawlt werden, ob das Crawl-Budget auf irrelevante Inhalte verschwendet wird und wo technische Barrieren liegen. Ergänzend lassen sich mit KI-Optimierung Muster in Logfiles schneller erkennen, Crawling-Frequenzen intelligenter steuern und Indexierungsprobleme datenbasiert priorisieren.

Gerade moderne Webseiten auf Basis von React, Angular oder Vue stellen Webcrawler vor große Herausforderungen – wichtige Inhalte sind oft erst nach dem Rendering im Browser sichtbar. Tools wie Screaming Frog mit aktiviertem JavaScript-Rendering oder das URL-Inspektionstool der Google Search Console machen sichtbar, was der Crawler im Web wirklich verarbeitet. Damit schließt du gefährliche Lücken zwischen Nutzeransicht und Bot-Sicht – ein entscheidender Schritt, um auch dynamisch geladene Inhalte korrekt indexieren zu lassen.

Webcrawling ist kein Selbstläufer. Bereits kleine technische Fehler können Suchmaschinen-Bots ausbremsen oder in Sackgassen führen. Besonders problematisch sind sogenannte Crawler-Fallen, die durch Session-IDs, unendliche Scrollfunktionen oder überladene Filterstrukturen entstehen. Gerade automatisch generierte Inhalte bergen das Risiko von Redundanzen. Deshalb ist es wichtig, beim KI-Texte schreiben auf eindeutige Struktur, semantische Vielfalt und klare Markups zu achten. Auch Duplicate Content, der sich aus URL-Parametern oder Druckversionen ergibt, führt zu ineffizientem Webcrawling und signaltechnischer Verwässerung. Wird zusätzlich die Serverlast zu hoch, reagieren Crawler mit Rückzug – die Folge: Seiten bleiben unentdeckt. Kritisch sind auch Black-Hat-Techniken wie Cloaking oder Link-Spamming: Sie täuschen Inhalte oder manipulieren die Bot-Perspektive und führen im schlimmsten Fall zu Abstrafungen. Wenn du auf nachhaltiges SEO setzt, musst du die Webcrawling-Basics technisch sauber halten.

Wenn Google deine Inhalte nicht vollständig erfasst, bleibt selbst der beste Content unter dem Radar. Technische Schwächen wie fehlerhafte Canonicals, ineffiziente Seitenstrukturen oder langsame Ladezeiten wirken sich direkt auf Indexierung und Sichtbarkeit aus. Umso wichtiger ist es, das Webcrawling strategisch zu lenken – vom Aufbau der internen Verlinkung bis zur Optimierung von Mobile-Performance und semantischem HTML. Hier setzen die SEO-Leistungen der SUCHHELDEN an: Wir analysieren, strukturieren und verbessern deine Website technisch so, dass Suchmaschinen reibungslos durch deine Inhalte navigieren – und genau die Seiten erfassen, die Top-Rankings bringen. Als GEO-Agentur kombinieren wir technisches SEO mit generativer Engine Optimization, damit deine Inhalte indexiert und in KI-Antwortboxen optimal ausgespielt werden. Ergänzt durch intelligenten Linkaufbau, sorgen wir dafür, dass neue Inhalte schneller im Index landen und deine Domain an Autorität gewinnt. Sichtbarkeit beginnt bei uns im Detail und endet bei messbarem SEO-Erfolg.

Fehler finden – Performance entfalten

Ob Canonical-Konflikte, JavaScript-Probleme oder Indexierungsfehler: Unsere technische SEO-Beratung bringt Klarheit ins System. Wir identifizieren technische Blockaden, optimieren Quellcode und strukturieren deine Seitenarchitektur so, dass Crawler effizient arbeiten – unabhängig von CMS oder Website-Größe. Ideal für Unternehmen, die ihre Performance auf ein skalierbares technisches Fundament stellen wollen.

Struktur, die Wirkung zeigt

Erfolgreiches Webcrawling basiert auf einer Strategie, die Technik, Struktur und Inhalte in Einklang bringt. Wir entwickeln smarte SEO-Strategien, die deine Seitenarchitektur vereinfachen, Prioritäten im Crawling setzen und relevante Inhalte optimal auffindbar machen. So entsteht eine starke Basis für nachhaltige Rankings, bessere Indexierungsraten – und langfristiges Wachstum deiner Sichtbarkeit im Netz.

Website-Check für Top-Rankings

Ein ganzheitliches SEO-Audit deckt Schwachstellen auf, bevor sie Sichtbarkeit kosten. Die Profis der SUCHHELDEN analysieren Serverantwortzeiten, Crawling-Fehler, interne Verlinkung, Pagespeed und die Indexierungslogik – datenbasiert und systematisch. Dabei erhältst du nicht nur einen Status quo, sondern eine konkrete Roadmap zur Optimierung deiner Website nach technischen, strukturellen und inhaltlichen Kriterien.

Mehr Relevanz durch Reichweite

Crawling endet nicht an deiner Domain-Grenze. Unsere Offpage-Optimierung stärkt die externe Wahrnehmung deiner Website durch gezielten Linkaufbau, thematisch relevante Backlinks und die strategische Platzierung auf hochwertigen Plattformen. So entstehen digitale Eintrittspunkte, die dein Webcrawling beschleunigen und dein Google-Ranking nachhaltig verbessern – auch für neue oder aktualisierte Inhalte.

Bei uns bekommst du fundierte Expertise, effektive Strategien und ganzheitliches Online-Marketing – alles aus einer Hand. Gemeinsam optimieren wir deine digitale Präsenz und bringen dein Business nachhaltig voran.

Webcrawling ist weit mehr als technisches Grundrauschen – es ist der erste Impuls deiner Sichtbarkeit in den Suchergebnissen. Ohne saubere Strukturen, präzise Signale und eine indexierungsfreundliche Architektur bleibt selbst starker Content unsichtbar. Genau hier liegt der Unterschied zwischen Mitlaufen und Auffallen. Eine leistungsstarke Suchmaschinenoptimierung beginnt dort, wo der Crawler effizient im Web arbeiten kann – und entfaltet ihr Potenzial in klaren Prozessen, die Technik und Strategie vereinen. Wer online gefunden wird, hat vorher verstanden, wie Sichtbarkeit wirklich funktioniert – im Quellcode, im Webcrawling und in den Köpfen der Zielgruppe.

Die SUCHHELDEN machen aus technischen Voraussetzungen digitale Marktvorteile. Mit strategischer Präzision, technischer Expertise und langjähriger Erfahrung in B2B und B2C verwandeln wir deine Website in ein echtes Crawler-Magnetfeld. Statt nur Seiten freizugeben, schafft unsere SEO-Agentur Strukturen, die indexiert, verstanden und gerankt werden – dauerhaft und nachvollziehbar. So wird Webcrawling zur tragenden Säule deiner Sichtbarkeit und deine Website zur Antwort auf das, was Nutzer:innen wirklich suchen.

Deine Marke verdient es, sichtbar zu sein. Lass uns gemeinsam Strategien entwickeln, die Ergebnisse liefern – individuell, effektiv und nachhaltig.

Technische Klarheit für bessere Rankings schaffen

Ob du Webcrawling-Fehler beheben oder deine Seitenstruktur analysieren willst: Wir helfen dir, dein technisches SEO-Potenzial vollständig auszuschöpfen. Unsere Expert:innen prüfen systematisch, wie Webcrawler deine Inhalte erfassen – von der robots.txt über die Indexierbarkeit bis zur internen Verlinkung.

Dabei decken wir Schwachstellen auf, zeigen dir konkrete Lösungswege auf und verbinden Technik mit Strategie. So wird aus Analyse nachhaltige Sichtbarkeit.

Webcrawling verstehen – Potenziale erkennen

Die meisten Probleme im Ranking entstehen nicht durch Content, sondern durch Barrieren im Quellcode. Wir analysieren, wie gut deine Website für Bots zugänglich ist und zeigen dir, wie du daraus einen echten SEO-Vorteil machst.

Ein Webcrawler ist ein automatisiertes Programm, das Webseiten systematisch durchsucht und analysiert. Suchmaschinen wie Google setzen ihn ein, um neue Inhalte zu entdecken, bestehende Seiten zu prüfen und diese anschließend für die Indexierung vorzubereiten. Der Crawler folgt internen und externen Links, liest Quellcode, Metadaten und Inhalte aus und entscheidet, was in den Suchergebnissen erscheint.

Typische Einsatzbereiche:

Kurz gesagt: Ohne Webcrawler keine Sichtbarkeit – sie sind die Grundlage für jede Suchmaschinenoptimierung.

Webcrawler lassen sich in verschiedene Typen unterteilen – je nach Ziel, Datenbedarf und technischer Ausrichtung.

Die wichtigsten Arten:

Jeder Crawler-Typ folgt eigenen Regeln. Wenn du die Unterschiede verstehst, kannst du deine Website technisch so strukturieren, dass relevante Bots effizient arbeiten – ein klarer SEO-Vorteil.

Webcrawling bezeichnet den automatisierten Prozess, bei dem sogenannte Crawler oder Bots das Internet durchforsten, um Webseiten zu analysieren und deren Inhalte für Suchmaschinen aufzubereiten. Dabei besuchen sie systematisch URLs, extrahieren Texte, Bilder oder Metadaten und folgen internen sowie externen Links.

So funktioniert Webcrawling im Überblick:

Ohne sauberes Webcrawling können selbst hochwertige Inhalte nicht in den Google-Index gelangen und bleiben damit unsichtbar. Für eine effektive Suchmaschinenoptimierung ist Webcrawling daher wichtig.

Webcrawling bildet die technische Grundlage jeder erfolgreichen SEO-Strategie. Nur wenn Suchmaschinen deine Website vollständig durchsuchen können, lassen sich Inhalte indexieren und bewerten. Dabei analysiert der Crawler Texte, Links, Strukturen und semantische Signale – er versteht, wie deine Seite aufgebaut ist und welche Inhalte wichtig sind. Ohne diesen Prozess bleibt selbst hochwertiger Content unsichtbar für Google. Erst ein reibungsloser Crawl ermöglicht es, Relevanz, Autorität und Aktualität korrekt einzuordnen – und damit dein Ranking gezielt zu stärken. Webcrawling ist also nicht optional, sondern essenziell für nachhaltige Sichtbarkeit.

Damit Webcrawler deine Inhalte vollständig erfassen und richtig einordnen, braucht deine Website eine klare Struktur, leistungsstarke Technik und aussagekräftige Inhalte. Wichtig sind sauberer HTML-Code, eine logische interne Verlinkung sowie sprechende URLs. Nutze strukturierte Daten, um Suchmaschinen den Kontext zu vermitteln, und pflege eine aktuelle XML-Sitemap. Für mobile Geräte optimierte Darstellung, schnelle Ladezeiten und eine stabile Server-Performance erhöhen zusätzlich die Crawl-Effizienz. Auch die Anmeldung deiner Website in der Google Search Console unterstützt die Indexierung – so werden neue oder geänderte Seiten schneller erkannt. Je besser deine Seite technisch aufgestellt ist, desto höher sind deine Chancen auf Top-Rankings.

Für ein effizientes Webcrawling gibt es spezialisierte Tools, die technische Fehler aufdecken und Crawling-Daten strukturiert bereitstellen. Beliebt sind Screaming Frog für detaillierte Website-Analysen, Sitebulb für visuelle Crawl-Berichte und DeepCrawl für große Enterprise-Projekte. Google Search Console liefert zusätzlich wertvolle Crawling- und Indexierungsdaten direkt von Google. Diese Tools helfen, Broken Links, Duplicate Content, langsame Ladezeiten und andere Barrieren zu identifizieren.

Webcrawling sorgt dafür, dass Suchmaschinen Inhalte technisch korrekt erfassen und semantisch einordnen können – eine Grundvoraussetzung für KI-Antwortboxen wie Google AI Overview. Entscheidend sind eine klare HTML-Struktur, saubere Headings (H1–H3), Listen und Tabellen sowie der Einsatz von strukturierten Daten (Schema.org). So können generative Systeme Informationen extrahieren und als präzise Antwort darstellen.